Model Context Protocol (MCP) – Brücke zwischen KI und Datenwelt

.png)

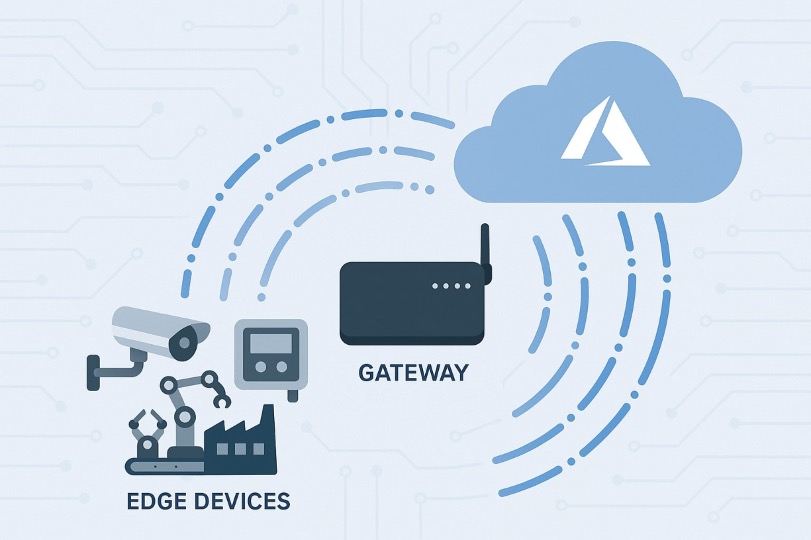

Große Sprachmodelle beeindrucken mit ihrem Allgemeinwissen – bis man eine unternehmensspezifische Frage stellt. In der Praxis stoßen Large Language Model (LLMs) schnell an Grenzen, weil ihnen der Zugriff auf interne Daten und Tools fehlt. Wertvolles Wissen liegt in Datensilos wie Wikis, Ticketsystemen oder Datenbanken, die für den Chatbot unzugänglich bleiben. Ein KI-Assistent kann vielleicht erklären, wie man ein Support-Ticket erstellt, doch ohne Anbindung an die firmeneigene Schnittstelle kann er kein konkretes Ticket mit realen Kundendaten anlegen.

Die Folge: Das volle Potenzial der KI bleibt ungenutzt, weil entscheidender Datenkontext fehlt. Genau hier setzt das Model Context Protocol (MCP), das dieses Problem adressiert.

Dieser offene Standard, Ende 2024 von Anthropic initiiert und inzwischen von den meisten führenden KI-Anbietern unterstützt, definiert einen einheitlichen Weg, wie KI-Anwendungen auf unterschiedliche Datenquellen und Tools zugreifen können.

Statt für jedes System eigene Schnittstellen zu entwickeln, genügt künftig die Implementierung eines einzigen standardisierten Protokolls. Dieser Artikel beleuchtet die Schwächen bisheriger Insellösungen, erklärt, wie MCP diese grundlegend überwindet, und zeigt, wie Unternehmen den Standard nutzen können, um das volle Potenzial ihrer KI-Investitionen auszuschöpfen.

Status quo & Herausforderungen

Ohne MCP müssen KI-Lösungen für jede einzelne Datenquelle separat angebunden werden. Das führt zu einem Flickenteppich aus Skripten und Plugins für Datenbanken, Dateisysteme und APIs. Solche individuellen Integrationen sind zeitaufwendig, fehleranfällig und schwer zu warten.

Die Folgen sind isolierte Informationsinseln und permanenter Kontextverlust. Unternehmenswissen aus Jira, Confluence oder CRM-Systemen bleibt für KI-Assistenten unzugänglich, was ineffiziente Workflows und eine erhöhte Fehleranfälligkeit zur Folge hat.

Der Kern des Problems liegt in der Vielzahl inkompatibler Schnittstellen. Jede Datenquelle bringt eigene Authentifizierung, Datenformate und Fehlerbehandlung mit sich. Sobald sich eine API ändert, bricht die Integration leicht zusammen und Entwicklerteams müssen erneut nachbessern.

Am Ende bleibt den KI-Modellen der Zugriff auf aktuelle Unternehmensdaten verwehrt. Sie sind auf ihr statisches Trainingswissen beschränkt und stoßen dadurch schnell an Grenzen in der produktiven Nutzung.

Technischer Deep-Dive

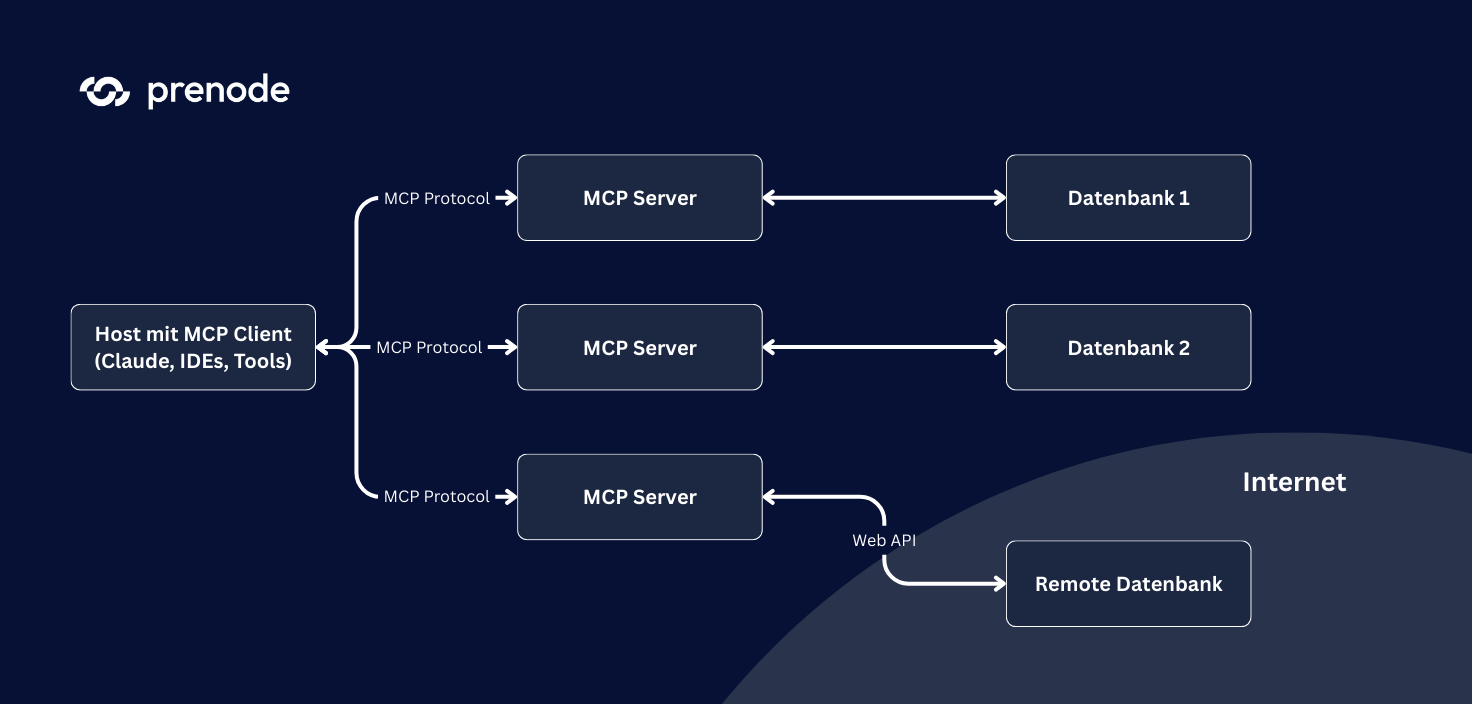

MCP basiert auf einem klar definierten Client-Server-Modell und erweitert bewährte Web-Technologien um KI-spezifische Funktionen. Die Architektur folgt dem Prinzip der Separation of Concerns und ermöglicht modulare, skalierbare Integrationen.

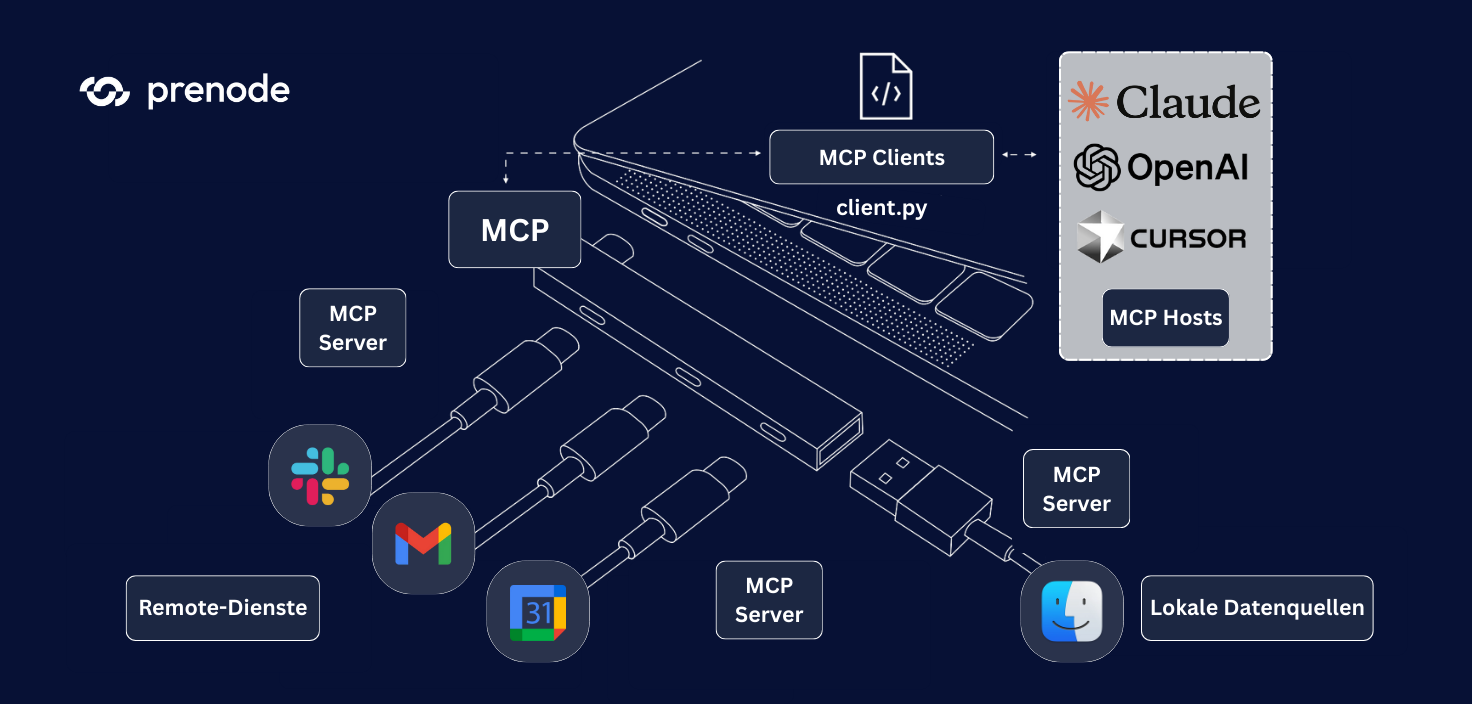

MCP-Host

Der MCP-Host fungiert als zentrale Steuerungseinheit und läuft in der Regel innerhalb der KI-Anwendung (z. B. IDE-Plugin, Chatbot-Umgebung oder Desktop-Applikation). Er verwaltet eine oder mehrere Client-Instanzen und überwacht sowohl Sicherheitsaspekte als auch Zugriffsrechte. Der Host stellt sicher, dass ein KI-Client ausschließlich auf die Ressourcen zugreift, für die explizite Berechtigungen vorliegen.

Darüber hinaus integriert er Policy-Management, Sitzungsverwaltung und Kontext-Koordinierung in einer konsistenten Architekturkomponente. In Enterprise-Umgebungen kann der Host zusätzlich Funktionen wie Logging, Monitoring und Compliance-Überwachung übernehmen und so den sicheren und nachvollziehbaren Betrieb gewährleisten.

MCP-Client

Eine MCP-Client-Instanz repräsentiert genau eine KI-Sitzung mit einem MCP-Server. Sie bildet die Brücke zwischen der KI-Anwendung und einem externen Tool und eröffnet dafür einen zustandsbehafteten Kommunikationskanal (Session). Über diesen Kanal werden verfügbare Fähigkeiten ausgehandelt (Capability Negotiation).

Jede KI-Agent-Instanz läuft isoliert in ihrer eigenen Client-Umgebung, sodass keine unbefugten Zugriffe zwischen verschiedenen Agents möglich sind. Häufig ist der Client Teil eines Software Development Kits (SDK) – etwa für Python, TypeScript oder Go – das die Protokoll-Details abstrahiert und Entwicklern eine leicht nutzbare API zur Verfügung stellt.

MCP-Server

Ein MCP-Server fungiert als standardisierter Adapter für externe Ressourcen – beispielsweise lokale Komponenten wie Dateisysteme oder Datenbanken sowie entfernte Services wie Cloud-CRM-Systeme oder APIs. Er stellt diese Ressourcen in Form von definierten „Tools“ und „Resources“ über MCP bereit und deklariert klar spezifizierte Funktionen.

Alle Server folgen den gleichen Kommunikations- und Formatregeln des Protokolls, wodurch sie von jedem MCP-Client angesprochen werden können. Ein einzelner Server kann mehrere thematisch verwandte Funktionen bündeln – etwa alle Operationen eines CRM-Systems oder sämtliche Dateisystem-Zugriffe – und so als modularer Erweiterungsbaustein in die Gesamtarchitektur eingebunden werden.

Kommunikation und Protokoll

MCP verwendet JSON-RPC 2.0 als standardisiertes Nachrichtenformat für den Austausch von Kommandos und Abfragen zwischen Client und Server. Die Kommunikation erfolgt über persistente Verbindungen, wodurch interaktive und zustandsbehaftete Sitzungen möglich werden – im Gegensatz zu klassischen, zustandslosen REST-APIs.

Für lokale MCP-Server wird die Verbindung in der Regel über stdin/stdout-Pipes realisiert, während Remote-Server typischerweise über WebSockets oder Server-Sent Events angebunden werden. Ein zentrales Merkmal ist die dynamische Dienst-Erkennung: Sobald ein neuer MCP-Server aktiv ist, kann ein Client ihn automatisch entdecken und dessen Fähigkeiten anhand eines standardisierten Manifests auslesen.

Sicherheit und Isolation

MCP setzt auf mehrere komplementäre Sicherheitsebenen. Auf Client-Seite sorgt der Host für Sandboxing, Rechteverwaltung und die konsequente Trennung von Sitzungen. Serverseitig können zusätzliche Mechanismen wie Authentifizierung und Autorisierung implementiert werden. Die Kommunikation zwischen Client und Server lässt sich verschlüsseln, wodurch auch der Austausch sensibler Daten abgesichert ist.

Jede Sitzung ist strikt isoliert, sodass keine unbefugten Zugriffe zwischen unterschiedlichen Agents oder Ressourcen erfolgen können. Diese Architektur ermöglicht es, selbst geschäftskritische und vertrauliche Unternehmensressourcen sicher über MCP einzubinden.

Durch diese Architektur sinkt die Integrationskomplexität erheblich: Anstelle einer aufwendigen N×M-Verknüpfung (jeder Client einzeln mit jedem Tool) genügt eine klare N+M-Struktur – jeder Client spricht MCP, jedes Tool spricht MCP. Das Ergebnis sind modulare und erweiterbare KI-Systeme, in denen sich neue Fähigkeiten durch das einfache Hinzufügen eines Servers nahtlos integrieren lassen.

Damit etabliert MCP einen zukunftsfähigen Standard, der Interoperabilität fördert, Sicherheit gewährleistet und den Entwicklungsaufwand signifikant reduziert.

Herausforderungen bei der Einführung

Trotz seiner Vorteile bringt MCP bei der Implementierung in bestehende Prozesslandschaften praktische Hürden mit sich.

Ein zentrales Thema ist die Datenverfügbarkeit: MCP kann nur auf digitalisierte und strukturierte Informationen zugreifen. Viele Organisationen müssen deshalb zunächst sicherstellen, dass relevante Datenquellen identifiziert und zugänglich sind. Hinzu kommt die Frage der Datenqualität. Fehlerhafte oder veraltete Informationen werden durch MCP nicht korrigiert, weshalb eine konsequente Datenpflege und die Bereinigung von Dubletten vorab notwendig sind. Der Einsatz von Retrieval-Augmented Generation (RAG) kann die Kontextqualität verbessern.

Auch die Integration in bestehende Prozesse stellt eine Herausforderung dar. MCP ersetzt Punkt-zu-Punkt-Schnittstellen durch einen Integrations-Layer, was in Enterprise-Umgebungen häufig zentrale MCP-Server und eine klare Einbettung in die vorhandene IT-Infrastruktur erfordert.

Darüber hinaus spielt die Sicherheit eine entscheidende Rolle. MCP bringt zwar grundlegende Sicherheitsmechanismen mit, setzt aber stark auf die umgebende Infrastruktur. Für Web-basierte Anbindungen werden etablierte Standards wie OAuth und TLS genutzt, während in lokalen Szenarien Authentifizierung und Rechteverwaltung durch bestehende Systeme oder Policies ergänzt werden müssen. Schließlich sind Performance und Zuverlässigkeit wichtige Faktoren. MCP-Server verursachen zusätzliche Latenzen und müssen daher performant und hochverfügbar betrieben werden – inklusive Load Balancing, Monitoring und Fallback-Mechanismen.

Vorteile von MCP

Das Model Context Protocol (MCP) bietet einen standardisierten Rahmen für die Anbindung von KI-Systemen an ihre Umgebung und löst zentrale Integrationsprobleme:

Einheitliche Integration

MCP fungiert als universelle Schnittstelle: Einmal im KI-Client implementiert, können verschiedenste Datenquellen angebunden werden. Anstelle individueller API-Integrationen genügt ein einziges Protokoll. Neue Systeme lassen sich nach dem Plug-and-Play-Prinzip ergänzen, ohne die Architektur umzubauen.

Dynamische Kontext-Erweiterung

MCP ermöglicht persistente Zwei-Wege-Verbindungen zwischen Modell und Datenquelle. So können LLMs kontinuierlich Informationen abrufen und Aktionen ausführen – etwa in einer Wissensdatenbank recherchieren, Ergebnisse mit Kundendaten abgleichen und direkt ein Support-Ticket eröffnen.

Höhere Antwortqualität

Durch Zugriff auf aktuelle Daten steigt die Genauigkeit und Relevanz der Antworten deutlich. Modelle sind nicht mehr allein auf statisches Trainingswissen angewiesen, sondern können Live-Datenquellen nutzen.

Offenes Community-Ökosystem

Als offener Standard fördert MCP ein wachsendes Ökosystem von Erweiterungen. Bereits Anfang 2025 standen hunderte Community-Connectoren bereit – von GitHub über Slack bis hin zu Datenbank-Servern. Unternehmen profitieren von vorgefertigten Bausteinen und verkürzen Integrationszeiten erheblich.

Skalierbarkeit und Zukunftssicherheit

Die Entkopplung von Tools macht Architekturen flexibler und robuster. Neue Anforderungen lassen sich durch Hinzufügen eines MCP-Servers umsetzen. Da MCP modellagnostisch ist, können verschiedene LLM-Anbieter genutzt werden, ohne die Integrationsschicht neu aufbauen zu müssen.

Best-Practice-Beispiele

Um die Vorteile von MCP greifbar zu machen, folgen zwei Praxisbeispiele aus unterschiedlichen Anwendungsfeldern. Sie zeigen, wie konkrete Probleme gelöst und Mehrwert geschaffen werden kann:

1. Wissensmanagement – Jira und Confluence nahtlos in der KI-Assistenz

Ein globales Unternehmen setzt Jira für Aufgaben-Tracking und Confluence als Wissensbasis ein. Mitarbeiter verlieren viel Zeit, weil sie Informationen für Meetings oder Entscheidungen mühsam zwischen Tickets, Wiki und E-Mails zusammensuchen. Kontext aus diesen Tools gelangt nur manuell in KI-Systeme, was zu Verzögerungen und Lücken führt.

Lösung: Ein MCP-Server für Jira und Confluence stellt die Daten einheitlich bereit, während ein KI-Assistent als MCP-Client angebunden ist. Der Assistent kann direkt auf Tickets und Wissensseiten zugreifen, Abfragen stellen oder neue Vorgänge anlegen – abgesichert durch bestehende OAuth- und Berechtigungssysteme.

Ergebnisse: Mitarbeiter stellen Fragen in natürlicher Sprache und erhalten sofort Antworten, ohne die Anwendung wechseln zu müssen. Weniger Kontextwechsel ermöglicht schnellere Entscheidungen und mehr Fokus auf wertschöpfende Arbeit. Selbst komplexe Multi-Step-Aktionen, wie das gleichzeitige Erstellen mehrerer verknüpfter Tickets, lassen sich in einem Schritt erledigen.

2. Kundenservice-Assistenz – AI-Agent mit 360°-Blick auf Kundendaten

Ein E-Commerce-Anbieter bearbeitet Anfragen über viele Kanäle. Servicemitarbeiter müssen dafür CRM, Bestellhistorie, Wissensdatenbank und Ticketsystem manuell durchsuchen. Das kostet Zeit, verzögert Antworten und führt zu Inkonsistenzen.

Lösung: Über MCP werden alle relevanten Systeme verbunden und in einen Customer Support Assistant integriert. Ein KI-Chatbot kann direkt Kundendaten, Bestellstatus und Produktinformationen abrufen sowie bei Bedarf ein Ticket anlegen oder aktualisieren – alles innerhalb eines einzigen Dialogs in natürlicher Sprache.

Ergebnisse: Der Kundenservice wird schneller und präziser. Der Assistent berücksichtigt z. B., dass ein Kunde bereits mehrfach wegen desselben Problems angefragt hat, und reagiert entsprechend. Routinefragen werden automatisiert beantwortet, während Mitarbeiter sich auf komplexe Fälle konzentrieren. Neue Kanäle – etwa Social Media – können durch das Hinzufügen eines weiteren MCP-Servers unkompliziert eingebunden werden.

Fazit

Das Model Context Protocol ist ein entscheidender Schritt für die Weiterentwicklung von KI-Systemen. Es standardisiert die Anbindung an externe Tools, reduziert Integrationsaufwand und ermöglicht skalierbare, leistungsfähige Anwendungen.

Die Vorteile liegen auf der Hand: schnellere Integrationen, bessere Antwortqualität und geringere Wartungskosten. Zugleich wächst ein offenes Ökosystem an Connectoren, das neue Anwendungsfälle erschließt.

Für Unternehmen empfiehlt sich ein schrittweiser Einstieg über Pilotprojekte, kombiniert mit Investitionen in Datenqualität und Sicherheit. Wer früh handelt, kann sich Wettbewerbsvorteile sichern und seine KI-Landschaft zukunftssicher aufstellen.

Sichern Sie sich den Vorsprung:

In unserem Webinar "Mit KI Ausschreibungen gewinnen" erfahren Sie Schritt für Schritt, wie Sie mit LLMs und RAG Ausschreibungen effizienter bearbeiten und Ihre Erfolgsquoten langfristig deutlich steigern.

👉 https://www.meetup.com/karlsruhe-artifical-intelligence/events/310486152/

Teilen Sie diesen Artikel

.png)

%20(3000%20x%202000%20px).png)