Explainable AI in der Fertigung

%20(3000%20x%202000%20px).png)

KI-Anwendungen werden bereits regelmäßig in der Produktion eingesetzt, von der vorausschauenden Wartung bis zur automatischen Qualitätsprüfung. Doch in der Praxis stoßen viele Projekte an eine unsichtbare Grenze: mangelndes Vertrauen in die Modelle.

Wenn ein Algorithmus zwar präzise, aber intransparent arbeitet, zögern Fachkräfte, seine Empfehlungen umzusetzen. Die Folge: Ergebnisse werden manuell überprüft, Entscheidungen verzögern sich, Effizienzgewinne bleiben aus.

Genau hier setzt Explainable AI (XAI) an. Ziel ist nicht eine höhere Modellgenauigkeit, sondern mehr Nachvollziehbarkeit und Akzeptanz. Erklärbare KI ermöglicht es, algorithmische Entscheidungen technisch und fachlich zu interpretieren und schafft damit eine gemeinsame Grundlage für Mensch und Maschine.

Status quo & Herausforderungen

Das Problem ist weniger technischer, sondern organisatorischer Natur. Wenn Fachpersonal nicht versteht, warum eine Maschine laut Modell bald ausfallen soll, wird das Ergebnis meist hinterfragt und im Zweifel ignoriert.

Typische Auswirkungen in der Praxis:

- Vorausschauende Wartung: Das System meldet einen drohenden Lagerausfall, doch der Mechanismus dahinter bleibt unklar. Wartungsteams reagieren vorsichtig oder gar nicht, mit potenziell teuren Stillständen als Folge.

- Visuelle Qualitätsprüfung: Ein neuronales Netz stuft ein Bauteil als fehlerhaft ein, liefert aber keine visuelle Erklärung. Mitarbeitende prüfen erneut, teilweise mit gegenteiligem Ergebnis. Dadurch sinkt sowohl Durchsatz als auch Vertrauen in das System.

- Prozessoptimierung: Modelle zur Parametersteuerung zeigen zwar Korrelationen, aber keine kausalen Zusammenhänge. Ohne Erklärungen fehlt die Grundlage, Empfehlungen in der Praxis umzusetzen.

Der Engpass liegt in der Erklärbarkeit und Integration in den Arbeitsalltag. Unternehmen, die hier ansetzen, steigern Akzeptanz und Effizienz durch weniger Prüfaufwand und Fehlentscheidungen.

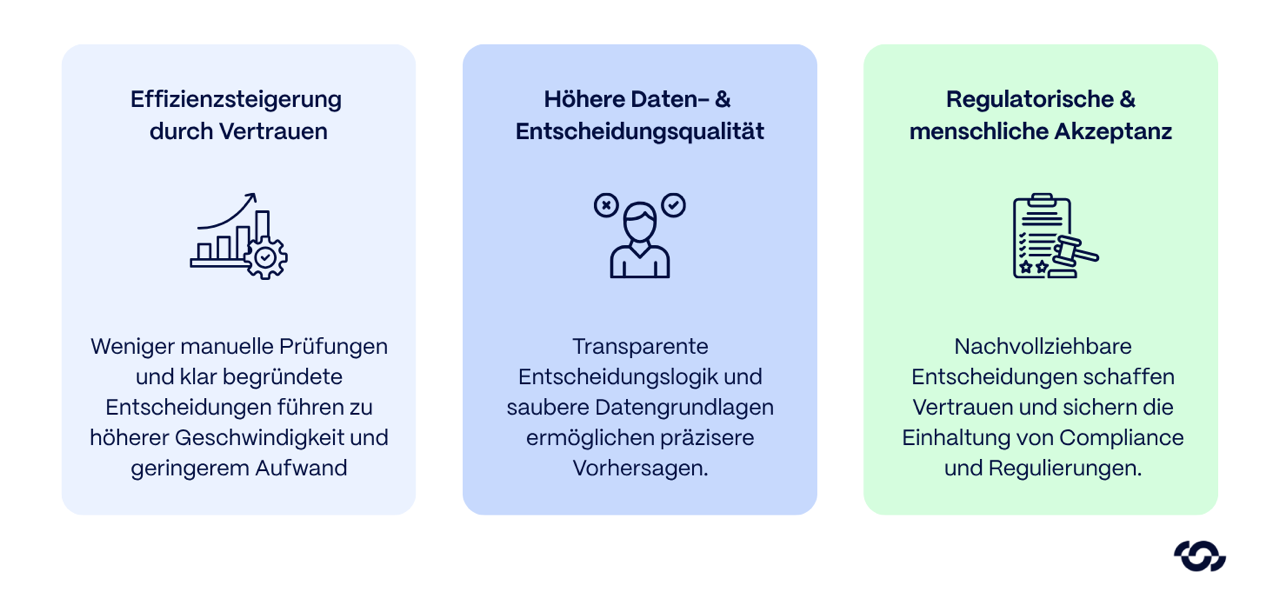

Nutzen moderner XAI-Lösungen

Der entscheidende Fortschritt von Explainable AI liegt darin, dass sie Black-Box-Modelle in überprüfbare Werkzeuge verwandelt. Während klassische KI oft nur „Was“ liefert, erklärt XAI auch das „Warum“. Dadurch entstehen messbare Vorteile in drei zentralen Bereichen der industriellen Praxis.

1. Effizienzsteigerung durch Vertrauen

In Fertigungsumgebungen sind Entscheidungen selten binär. Wenn eine KI-Vorhersage nicht nachvollziehbar ist, wird sie meist manuell geprüft – ein erheblicher Zeitfaktor.

XAI reduziert diesen Mehraufwand, indem sie Entscheidungen mit Ursachen belegt.

2. Höhere Daten- und Entscheidungsqualität

XAI schafft Transparenz über die Einflussfaktoren im Modell. Dadurch lassen sich systematische Fehler, fehlerhafte Sensoren oder unrepräsentative Trainingsdaten schneller identifizieren.

Das Ergebnis: saubere Datengrundlagen, nachvollziehbare Entscheidungslogik und präzisere Vorhersagen.

3. Stärkere Automatisierung durch regulatorische und menschliche Akzeptanz

Erklärbarkeit ist nicht nur eine technische, sondern zunehmend auch eine rechtliche Anforderung.

Mit strengeren Auflagen müssen Unternehmen bei bestimmten Hochrisiko-Anwendungen immer häufiger nachweisen, dass Entscheidungen nachvollziehbar dokumentiert werden können.

XAI-Mechanismen liefern die technische Basis dafür: automatische Erklärungs-Logs, Audit-Trails und Visualisierungen der Entscheidungswege.

Aber auch jenseits regulatorischer Vorgaben gilt: Transparente Systeme werden häufiger genutzt.

Technischer Deep-Dive: XAI-Methoden und -Techniken

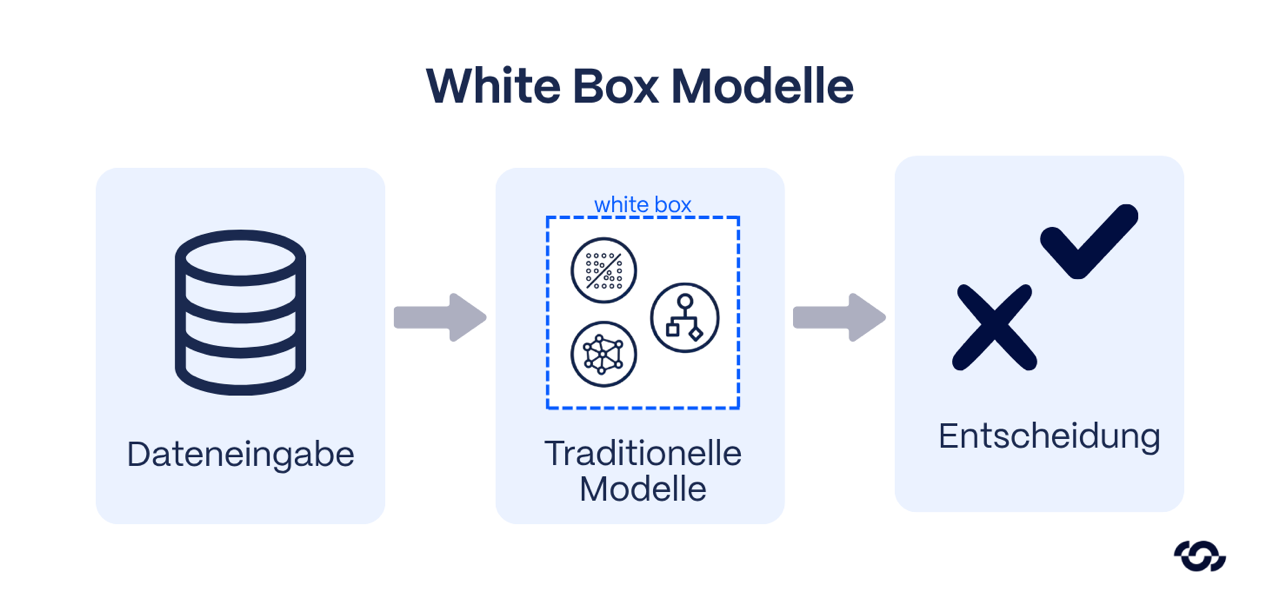

Explainable AI lässt sich grundsätzlich auf zwei Ansätze herunterbrechen:

(1) intrinsisch erklärbare Modelle, deren Struktur von sich aus verständlich ist

(2) nachträgliche (post-hoc) Verfahren, die komplexe Modelle interpretierbar machen.

In der industriellen Praxis kommen beide Varianten zum Einsatz – je nach Anwendungsfall, Datenlage und gewünschter Modellkomplexität.

Intrinsisch erklärbare Modelle

Bei intrinsisch erklärbaren Modellen ist die Logik unmittelbar nachvollziehbar.

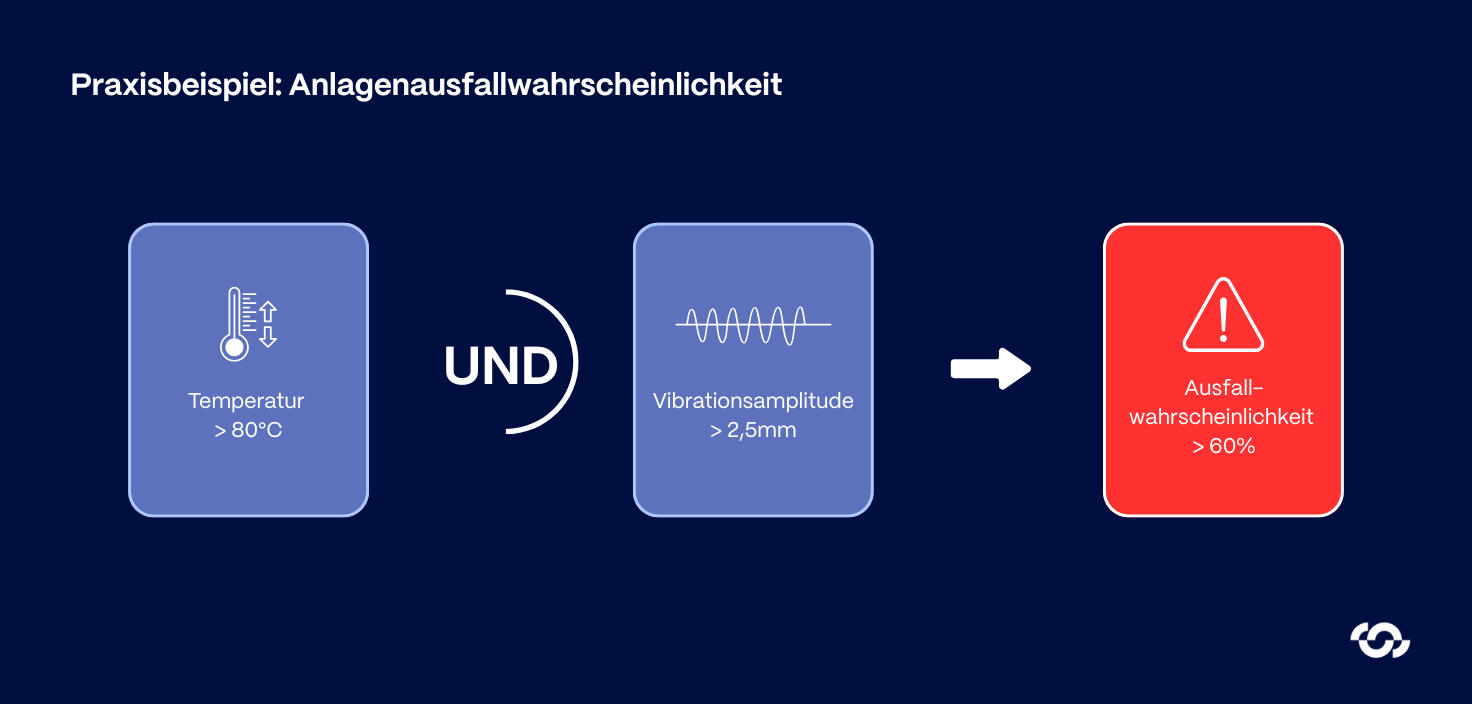

Klassische Beispiele sind Entscheidungsbäume, lineare Regressionsmodelle oder regelbasierte Systeme. Jeder Entscheidungspfad kann direkt mit fachlichem Wissen abgeglichen werden.

Solche Modelle sind leicht zu validieren und genügen oft regulatorischen Anforderungen. Ihr Nachteil: begrenzte Ausdrucksstärke bei hochdimensionalen Sensordaten oder nichtlinearen Zusammenhängen. In der Praxis werden sie daher häufig als Baseline oder Referenzmodell genutzt, um komplexere Black-Box-Ansätze zu prüfen.

Post-hoc-Erklärungen für Black-Box-Modelle

Leistungsfähigere Modelle – insbesondere tiefe neuronale Netze oder Ensemble-Verfahren – benötigen zusätzliche Erklärungsmechanismen. Hier kommen post-hoc-Methoden ins Spiel, die Entscheidungen im Nachhinein interpretierbar machen.

Feature Importance & SHAP

Verfahren wie SHAP (Shapley Additive Explanations) ordnen jedem Eingangsmerkmal einen quantitativen Einfluss auf die Vorhersage zu.

In der Fertigung bedeutet das: man sieht genau, wie stark Temperatur, Drehmoment oder Schwingungsfrequenz zur Ausfallprognose beitragen.

SHAP basiert auf spieltheoretischen Konzepten, liefert also „faire“ Beitragsschätzungen pro Feature.

Lokale Surrogat-Modelle (LIME)

LIME (Local Interpretable Model-Agnostic Explanations) erklärt einzelne Vorhersagen durch ein einfaches Ersatzmodell.

Beispiel: Für ein neuronales Netz, das ein Werkstück als defekt klassifiziert, erstellt LIME eine lokale lineare Regression, die diesen einen Datenpunkt imitiert. So lässt sich nachvollziehen, welche Variablen in dieser Situation ausschlaggebend waren.

LIME eignet sich besonders gut für interaktive Analysen – etwa in Dashboards, in denen Techniker „Warum genau dieses Teil?“ nachvollziehen wollen.

Kontrastive und gegenfaktische Erklärungen

Diese Methoden beantworten die Frage: „Was müsste anders sein, damit das Modell anders entscheidet?“

Ein Counterfactual könnte etwa zeigen, dass ein geringfügig niedrigerer Vibrationswert den Alarm verhindert hätte.

Für Ingenieure ist das besonders wertvoll, weil solche Erklärungen direkte Handlungsempfehlungen ermöglichen – sie zeigen nicht nur Ursachen, sondern auch Stellhebel.

Visuelle Heatmaps & Gradienten-basierte Verfahren

In der Bildverarbeitung – etwa bei der optischen Qualitätskontrolle – sind visuelle Erklärungen entscheidend.

Techniken wie Grad-CAM oder Integrated Gradients markieren Bildbereiche, die zur Entscheidung beigetragen haben. Auf einer Leiterplatte lassen sich so die Regionen hervorheben, die das Modell als fehlerhaft erkannt hat.

Der Vorteil: Die Erklärung ist visuell intuitiv und lässt sich leicht mit Fachwissen abgleichen.

Globale vs. lokale Erklärungen

- Lokale Erklärungen (z. B. LIME, SHAP) zeigen, warum eine einzelne Entscheidung so getroffen wurde.

- Globale Erklärungen analysieren das generelle Modellverhalten über viele Entscheidungen hinweg.

Ein globales Modell-Audit kann etwa offenlegen, dass ein Netz überproportional auf einen bestimmten Sensorkanal reagiert – ein Hinweis auf potenzielle Fehlkalibrierung oder Daten-Bias. Beide Perspektiven ergänzen sich: Lokal für Einzelfall-Transparenz, global für Modell-Validierung.

Praxisempfehlung

In industriellen Projekten bewährt sich ein hybrider Ansatz:

- intrinsisch erklärbare Modelle in frühen Projektphasen oder bei stark regulierten Anwendungen,

- post-hoc-Erklärungen bei komplexen Produktionsmodellen,

- kombiniert mit rollenabhängiger Aufbereitung – vom einfachen Ampelsignal für Werker bis zum SHAP-Diagramm für Data Scientists.

Der entscheidende Punkt ist nicht die Methode, sondern der kontextgerechte Einsatz. Eine technisch perfekte Erklärung nützt wenig, wenn sie für den Anwender unverständlich ist.

Best-Practice-Beispiele aus der Industrie

Praxisbeispiele zeigen am deutlichsten, wie Explainable AI in der Fertigung echten Mehrwert schafft. Die folgenden Fälle stammen aus Industrieprojekten und Pilotanwendungen, bei denen erklärbare Modelle zu höherer Prozesssicherheit, besserer Datenqualität und messbaren Kosteneinsparungen führten.

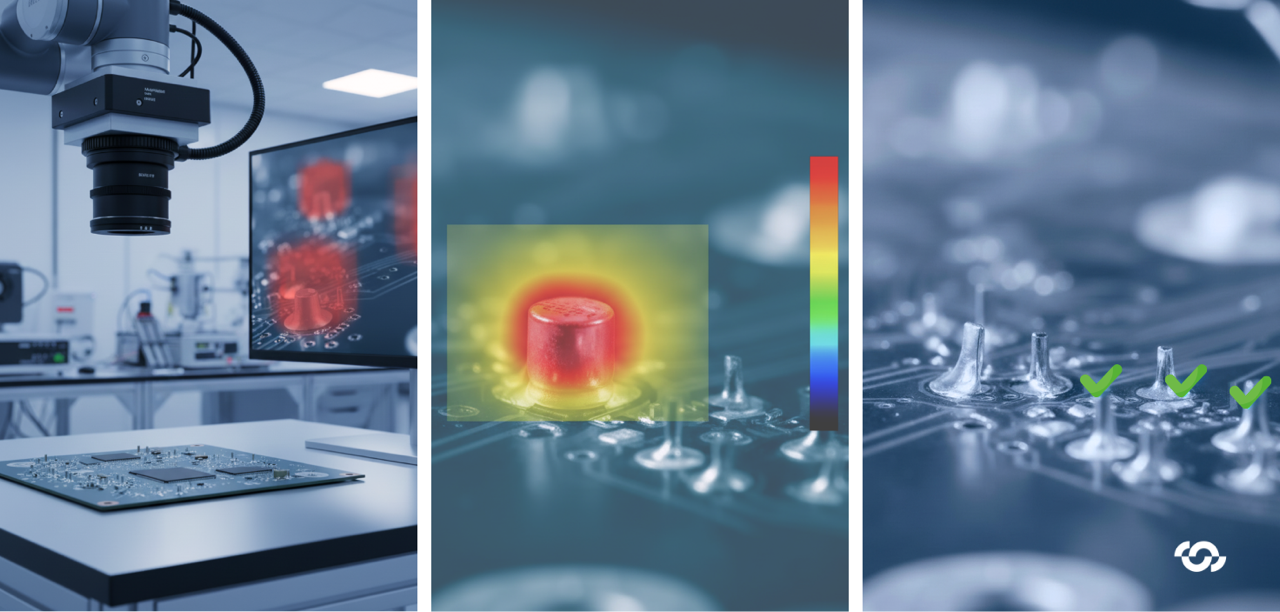

Use Case 1: Visuelle Qualitätsprüfung bei einem Elektronikfertiger

Ausgangslage:

Ein Hersteller elektronischer Baugruppen nutzte Deep-Learning-Modelle zur automatischen Prüfung von Lötstellen auf Platinen. Obwohl die Erkennungsrate hoch war, misstrauten die Prüfer dem System – es sortierte gelegentlich intakte Teile aus, ohne Begründung.

Lösung:

Das Data-Science-Team integrierte ein XAI-Modul auf Basis von Grad-CAM (Gradient-weighted Class Activation Mapping). Damit wurden für jedes analysierte Bild Heatmaps erzeugt, die die relevanten Bereiche visuell hervorhoben. So konnten Prüfer direkt erkennen, auf welcher Lötstelle das Modell einen Fehler vermutete.

Ergebnis:

- Deutlich höheres Vertrauen in die KI-Ausgabe – Fachkräfte verstanden, warum ein Teil als fehlerhaft galt.

- Messbare Reduzierung der Doppelprüfungen.

- Die Fehlklassifikationsrate sank signifikant, da echte Fehler und Fehlalarme besser unterscheidbar wurden.

Die Kombination aus Modellleistung und Erklärbarkeit führte hier zu messbar höherer Prüfsicherheit und geringeren Qualitätskosten.

Use Case 2: Daten-Validierung und Prozessüberwachung in der Automobilfertigung

Ausgangslage:

Ein Automobilzulieferer nutzte Machine-Learning-Modelle zur Prozessparameteroptimierung in der Kunststoffverarbeitung. Nach mehreren Modell-Updates fiel auf, dass Vorhersagen zunehmend unplausibel wurden – ohne offensichtliche Ursache.

Lösung:

Mit einem globalen XAI-Ansatz (Kombination aus SHAP Summary Plots und Partial Dependence Analysis) konnte gezeigt werden, dass ein Sensor-Feature mit systematischem Drift das Modell stark beeinflusste. Ursache war ein defekter Temperatursensor.

Ergebnis:

- Frühzeitige Erkennung eines Sensorfehlers, der ohne XAI monatelang unentdeckt geblieben wäre.

- Verbesserte Modellstabilität nach Retraining mit bereinigten Daten.

- Integration von XAI-Diagnosen in das bestehende MES zur kontinuierlichen Datenvalidierung.

XAI liefert hier nicht nur Erklärungen, sondern dient auch zur Qualitätsüberwachung.

Erkenntnisse aus der Praxis

Aus den Projekten lassen sich mehrere übergeordnete Lehren ableiten:

- Erklärbarkeit steigert Nutzungsrate: Modelle, deren Entscheidungen nachvollziehbar sind, werden von Fachkräften häufiger und konsequenter eingesetzt.

- XAI verbessert Datenqualität: Erklärungen decken systematische Anomalien auf – oft früher als klassische Monitoring-Systeme.

- Transparenz senkt Risiken: Verständliche Entscheidungslogik reduziert Fehlalarme und unnötige Eingriffe.

- Technische Umsetzung ist machbar: Mit heutigen Frameworks (z. B. Captum, SHAP, Alibi, TensorFlow Explain) lässt sich XAI ohne massiven Mehraufwand implementieren – entscheidend ist die Integration in bestehende Prozesse, nicht die reine Modellseite.

Die Industrieerfahrungen zeigen: Explainable AI ist kein theoretisches Konzept, sondern ein betriebswirtschaftlich und technisch relevanter Faktor. Wo klassische KI-Systeme oft am „Warum“ scheitern, ermöglicht XAI messbare Verbesserungen – bei Zuverlässigkeit, Effizienz und Vertrauen in datengetriebene Entscheidungen.

Fazit

Explainable AI entwickelt sich in der industriellen Praxis von einem Forschungsfeld zu einem klaren Produktivitäts- und Vertrauensfaktor.

Gerade in der Fertigung, wo Sicherheit, Zuverlässigkeit und Qualität entscheidend sind, kann KI ihr Potenzial nur entfalten, wenn ihre Entscheidungen nachvollziehbar sind.

Erklärbare KI schließt die Lücke zwischen komplexen Modellen und menschlicher Expertise. Sie macht sichtbar, warum ein System eine Entscheidung trifft, und erlaubt Fachkräften, diese Entscheidung zu prüfen, zu bestätigen oder gezielt zu korrigieren.

Unternehmen, die diesen Schritt frühzeitig gehen, profitieren doppelt:

- kurzfristig durch höhere Prozessstabilität und schnellere Entscheidungszyklen,

- langfristig durch Compliance-Sicherheit, robustere Modelle und eine datengetriebene Unternehmenskultur.

Technisch ist die Implementierung heute kein Hindernis mehr. Die entscheidende Herausforderung liegt darin, XAI systematisch in Daten- und Prozesslandschaften einzubetten, anstatt sie als isoliertes Analysewerkzeug zu betrachten.

Teilen Sie diesen Artikel

.png)

.png)