KI im Vertrieb: Automatisierte Ausschreibungsanalyse mit LLMs

Öffentliche Ausschreibungen spielen für viele Unternehmen eine große wirtschaftliche Rolle – in Deutschland betrug das Volumen vergebener öffentlicher Aufträge 2023 rund 123,5 Mrd. Euro [https://www.destatis.de/DE/Themen/Staat/Oeffentliche-Finanzen/Vergabestatistik/_inhalt.html].

Gleichzeitig sind Ausschreibungsprozesse auf Bieterseite extrem arbeitsintensiv und fehleranfällig. Jedes Ausschreibungsdossier umfasst oft mehrere hundert Seiten in unterschiedlicher Form (z.B. PDF, Word, Excel, gescannte Dokumente…) ohne einheitliches Layout.

Wichtige Fristen, Teilnahmebedingungen oder technische Spezifikationen sind über viele Anhänge verteilt. Ohne automatisierte Unterstützung investieren Fachkräfte oft Stunden oder gar Tage in die Erstprüfung jeder Ausschreibung. Durch die enge Verknüpfung formaler Anforderungen (korrekte Formulare, Einreichungsfristen) mit harten Ausschlusskriterien führt bereits ein kleiner Fehler zum Ausschluss eines Angebots. Die manuelle Bearbeitung bindet wertvolles Personal, führt zu „Ausschreibungsmüdigkeit“ und hohen Opportunitätskosten. Vor diesem Hintergrund sind Lösungen gefragt, die Effizienz und Präzision im Ausschreibungsmanagement verbessern und gleichzeitig die Einhaltung aller Compliance-Anforderungen sicherstellen.

Herausforderungen im Ausschreibungsprozess

- Heterogene Dokumente: Ausschreibungsunterlagen kommen in unterschiedlichsten Formaten (PDF, Word, Bilder) und Strukturen. Jede Vergabestelle gestaltet ihre Unterlagen individuell, was ein automatisches Parsen und Normalisieren erschwert. Ein robustes Preprocessing (Optical Character Recognition [OCR] für gescannte Dokumente) ist notwendig, um den Text überhaupt zu erfassen und in logische Abschnitte („Chunks“) zu zerlegen.

- Hoher manueller Aufwand: Ohne KI-Unterstützung werten Teams eine Ausschreibung oft stundenlang manuell aus. Laut einem Praxisbericht dauerten die Durchsicht und Extraktion entscheidungsrelevanter Informationen bisher 2 Stunden bis mehrere Tage pro Ausschreibung. Die Folge sind lange Durchlaufzeiten und eine sinkende Angebotsrate.

- Strikte Compliance: Öffentliche Vergabeverfahren schreiben genaue Einhaltung aller Vorgaben vor. Fehlende Nachweise oder Fristverletzungen führen unmittelbar zum Ausschluss. Für ein KI-System bedeutet das: Jede generierte Information (z. B. Abgabetermine, geforderte Zertifikate) muss faktisch korrekt und überprüfbar sein. Halluzinierte oder ungenaue Antworten wären hier katastrophal, da sie direkt zum Schaden des Bieters führen könnten.

- Komplexes Wissensmanagement: Die Angebotserstellung ist abteilungsübergreifend (Technik, Recht, Finanzen, Vertrieb) und erfordert oft den Rückgriff auf früheres Wissen. In vielen Unternehmen werden frühere Angebote und Compliance-Informationen aber nicht systematisch archiviert oder wiederverwendet. Dadurch wird Wissen nicht effektiv aufgebaut und jede Ausschreibung größtenteils von Grund auf neu geprüft.

Diese Faktoren machen klar: Ziel ist nicht nur eine Zeitersparnis, sondern vor allem ein verlässliches Ergebnis. Die KI-Lösung muss relevante Fakten präzise aus den Originaldokumenten extrahieren und ihre Antworten nach Möglichkeit mit Quellenangaben belegen, um menschliche Fachanwender zu überzeugen.

Lösungsansatz: Einsatz von LLMs und RAG

An dieser Stelle kommen Large Language Models (LLMs) ins Spiel. Moderne LLMs können große Textmengen verstehen und verarbeiten. Sie können relevante Passagen erkennen, Fragen beantworten oder Zusammenfassungen erstellen. Entscheidend ist jedoch, wie das Modell an das Wissen aus den Ausschreibungsdokumenten herangeführt wird. Standard-LLMs arbeiten mit ihrem im Training gelernten Wissen, das einen festen zeitlichen Cut-off und begrenzte Faktenkenntnis hat. Für faktische Aufgaben wie die Ausschreibungsanalyse reicht das nicht aus.

Retrieval-Augmented Generation (RAG) ist ein hybrider Architekturstil, der genau hier ansetzt. Bei RAG wird ein vortrainiertes LLM zur Laufzeit mit externen, aktuellen Quellen ergänzt. Konkret wird aus den Ausschreibungsunterlagen zunächst ein semantischer Suchindex aufgebaut (Embedding + Vektordatenbank). Auf eine Benutzeranfrage (z. B. „Welche Zertifizierungen werden gefordert?“) durchsucht ein Retriever diesen Index und liefert die relevantesten Textabschnitte. Erst diese Dokumentensegmente werden dem LLM übergeben, das auf ihrer Basis die Antwort generiert. Dadurch stützt sich das Modell nicht mehr nur auf sein internes “parametrisches Gedächtnis”, sondern auf explizit bereitgestellte Fakten.

Die Vorteile des RAG-Ansatzes für Ausschreibungsanalysen sind zentral:

- Faktenbasiertheit & Transparenz: Da das LLM seine Antworten aus den abgerufenen Dokumenten konstruiert, sind die Informationen in den Quellen verankert. Das Modell kann relevante Textstellen als Belege zitieren. RAG-Systeme reduzieren somit die Fehler- und Erfindungsrate und senken damit das Risiko von Halluzinationen. Für Anwender bedeutet dies, dass sie die KI-Antwort unmittelbar gegenprüfen können, was das Vertrauen in das System stärkt.

- Aktualität und Dynamik: Die Wissensbasis (hier: die Ausschreibungsdokumente) bleibt unabhängig vom Modell und kann laufend ergänzt werden. Neue Dokumente werden einfach indexiert, ohne das LLM neu trainieren zu müssen. Dies stellt sicher, dass das System immer mit den aktuellsten Daten arbeitet. Im Gegensatz dazu wäre ein reines Fine-Tuning des LLM auf den Ausschreibungsstapel teuer und unpraktisch, da jeder Vergabeprozess neue Daten bringt.

- Kosten- und Rechenaufwand: Weil keine aufwändigen Trainingsläufe nötig sind, verschiebt sich der Aufwand ins einmalige Indexieren und in schnelle Abrufe. Dies ist in der Regel kosteneffizienter als kontinuierliches Neutrainieren großer Modelle. Ein weiterer Vorteil: Sensible Daten bleiben in der firmeneigenen Datenbank und werden erst bei Bedarf in den Prompt eingefügt – anders als bei Cloud-APIs, bei welchen jedes Promptelement extern gesendet wird. Viele Unternehmen setzen daher auf private LLM-Instanzen oder On-Premise-Lösungen, um volle Kontrolle über vertrauliche Ausschreibungsinhalte zu behalten.

RAG nutzt also die Stärken beider Welten – die generative Sprachfähigkeit von LLMs und die zuverlässige Informationsquelle aus einem speziellen Dokumentenkorpus – und bietet so die notwendige faktische Fundierung und Nachvollziehbarkeit für die Ausschreibungsanalyse. Die Technologie ermöglicht faktentreue, überprüfbare Antworten und damit höhere Sicherheit im gesamten Prozess.

Technische Architektur eines RAG-Systems

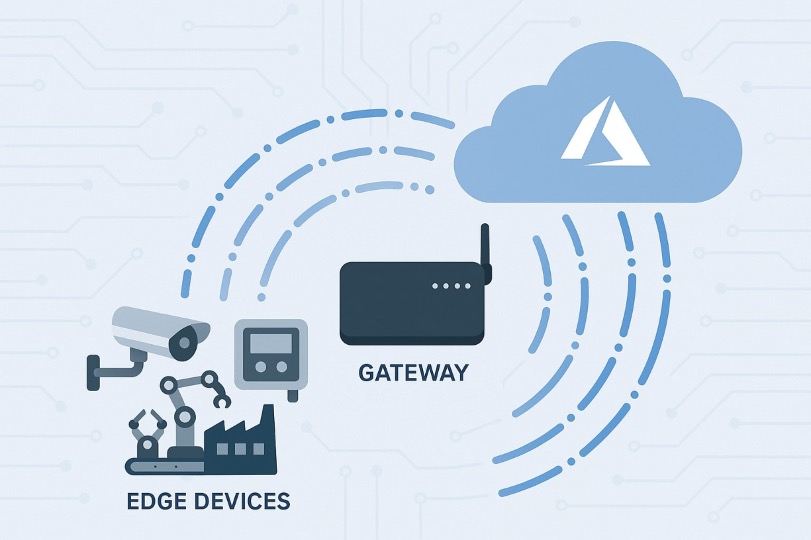

Ein praktisches RAG-System für Ausschreibungsmanagement gliedert sich typischerweise in drei Hauptkomponenten: Ingestion & Vorverarbeitung, Indexierung & Retrieval, sowie Generierung & Synthese. Die folgenden Schritte skizzieren den Ablauf:

- Dokumenten-Ingestion und Preprocessing: Eingehende Ausschreibungsunterlagen (PDF, Word, Bilddateien) werden zu Text verarbeitet. OCR-Verfahren extrahieren den Inhalt aus Scans, parallele Parser zerlegen Word- oder PDF-Dokumente. Anschließend wird der Text in sinnvolle Chunks segmentiert (z. B. Absatz- oder Kapitelebene), um die Granularität der Suche zu steuern. Jedem Chunk werden Metadaten zugeordnet (Dokumentenname, Abschnittsüberschrift, Seitenzahl), die später für Quellenangaben dienen. Diese Vorverarbeitung stellt sicher, dass strukturierte Informationen erhalten bleiben und die spätere Suche präzise auf relevante Abschnitte zugreifen kann.

- Indexierung & Retrieval: Jeder Text-Chunk wird durch einen Einbettungs-Encoder (z. B. einen Sentence-Transformer) in einen semantischen Vektor umgewandelt. Diese Vektoren werden in eine spezialisierte Vektordatenbank eingespeichert (z.B. Pinecone, Weaviate oder Milvus). Beim Abruf wandelt das System die Benutzeranfrage in einen Abfrage-Vektor um und sucht nach den semantisch ähnlichsten Chunks. Oft wird ein hybrides Suchverfahren eingesetzt: Eine dichte Vektorsuche für semantische Relevanz wird mit klassischen Schlüsselwortsuchen (z. B. BM25) kombiniert, um Fachtermini oder exakte Begriffe zuverlässig zu finden. Anschließend können die Top-K gefundenen Chunks noch einmal durch ein Re-Ranking neu sortiert werden, um den wirklich relevanten Kontext für das LLM zu maximieren.

- Generierung & Ergebnis-Aufbereitung: Die abgerufenen Dokumentenausschnitte werden mit der Nutzerfrage in einen Prompt für das LLM eingebettet. Mittels detailliertem Prompt Engineering wird das Modell angeleitet, die Antwort ausschließlich aus den gelieferten Texten herzuleiten. Das LLM synthetisiert die Informationen aus mehreren Chunks und erstellt eine prägnante Antwort. Dabei kann es auf verschiedene Ausgabeformate zielen:

- Zusammenfassung der wichtigsten Ausschreibungsinhalte (Leistungsumfang, Fristen, Eignungskriterien).

- Strukturierte Extraktion in Form von Tabellen oder JSON (z. B. Checklisten mit Anforderungen, Fristen, benötigten Nachweisen).

- Frage-Antwort-Modus: Über eine Chat-Oberfläche kann der Anwender nachträglich spezifische Fragen zu den Dokumenten stellen. Das System sucht erneut passende Textstellen und formuliert eine Antwort mit Quellenbezug.

In allen Fällen bleiben die Quellenverweise erhalten. Durch die Metadaten jedes Text-Chunks kann das System z.B. Seitenzahlen oder Dokumenttitel angeben. So kann der Anwender etwa „Siehe Abschnitt 4.2 im Dokument X“ als Nachweis erhalten. Diese Nachvollziehbarkeit ist für Audits und interne Reviews essenziell.

Die gesamte Architektur kann über standardisierte Schnittstellen in die Unternehmens-IT integriert werden (z.B. via REST-APIs). Somit fließt die KI-gestützte Analyse als Modul in bestehende Workflows ein – von der ersten Risikoabschätzung bis zur Angebotserstellung.

Anwendungsfall

Ein IT-Systemhaus, das regelmäßig an komplexen, öffentlichen Ausschreibungen teilnimmt, sah sich mit einer zeitintensiven und ineffizienten manuellen Bearbeitung der Ausschreibungsdokumente konfrontiert. Die manuelle Erstsichtung und Vorabprüfung benötigte im Schnitt 8 Stunden pro Ausschreibung und verursachte hohe Kosten durch verspätete Erkennung von Ausschlusskriterien.

Um diese Herausforderungen zu bewältigen, wurde ein RAG-basiertes System eingeführt. Dieses automatisiert die Verarbeitung der Ausschreibungen, extrahiert relevante Informationen und erstellt in kurzer Zeit prägnante Zusammenfassungen zur Entscheidungsunterstützung.

Die Ergebnisse der Implementierung zeigten deutliche Verbesserungen: Die Bearbeitungszeit für die initiale Sichtung wurde um rund 59 % reduziert. Dadurch konnten mehr Ausschreibungen bearbeitet werden, ohne das Personal aufzustocken. Zusätzlich berichteten die Anwender von einer spürbaren Entlastung und konnten ihren Fokus stärker auf die strategische Qualität der Angebote lenken.

Implementierung und Herausforderungen

Bei der Einführung einer RAG-Lösung gilt es, neben der Technik auch organisatorische Rahmenbedingungen zu beachten:

- Daten-Governance und Sicherheit: Ausschreibungsunterlagen enthalten oft vertrauliche Informationen (wie Preiskalkulationen oder Vertragsdaten). Ein sicheres Betriebsmodell ist daher Pflicht. Viele Unternehmen bevorzugen Private-Cloud ****oder On-Premise-Deployments der LLMs und der Vektordatenbank, um Datenlecks zu vermeiden. Zugriffsrechte müssen über das gesamte System durchgängig verwaltet werden, damit jeder Nutzer nur die ihm zustehenden Dokumente sehen kann. Die RAG-Architektur hat hier einen Vorteil: Die sensiblen Ausschreibungsdaten bleiben im geschützten Speicher und werden nur als Kontext-Chunk weitergereicht.

- Systemintegration: Das RAG-Tool sollte sich in bestehende Prozesse einfügen. Übliche Integrationspunkte sind E-Vergabe-Plattformen oder Dokumentenmanagementsysteme (DMS). Über APIs kann man Ausschreibungsunterlagen automatisch in den Preprocessing-Pool einspeisen und die resultierenden Checklisten oder Reports wieder an die Arbeitsplätze der Fachbereiche zurückliefern. So kann sichergestellt werden, dass keine Doppelarbeit entsteht und alle Abteilungen mit den gleichen Informationen arbeiten.

- Infrastruktur & Skalierung: Moderne Vektordatenbanken unterstützen horizontalen Ausbau (Sharding, verteilte Suche), um auch bei Millionen Dokumenten schnelle Antworten zu liefern. Für On-Premises-Betrieb müssen Firmen genügend Ressourcen (Speicher, GPUs für LLM) bereitstellen. Cloud-Anbieter bieten hier Managed Services (z. B. Vektor-Datenbanken, LLM-Endpunkte) an, was die Anfangshürde senkt. Caching häufiger Abfragen oder ein Daten-Tiering nach Zugriffshäufigkeit können zusätzlich helfen, Kosten zu kontrollieren.

- Wartung und Monitoring: Ein RAG-System benötigt kontinuierliche Pflege. Beispielsweise sollte das Index-Update automatisiert erfolgen, wenn neue Ausschreibungen eingehen. Leistung und Qualität können durch Monitoring-Metriken (Durchsatz, Antwortzeiten, Extraktionsgenauigkeit) und Nutzerfeedback überwacht werden. Regelmäßige Updates (z. B. bessere Embedding-Modelle, neuere LLM-Versionen) stellen sicher, dass das System mit aktuellen Fortschritten Schritt hält.

Fazit

Die Kombination aus LLM und Retrieval-Augmented Generation ist ein wirkungsvoller Ansatz, um Ausschreibungsprozesse in Industrieunternehmen effizienter zu machen. Durch den Einsatz eines RAG-Systems lässt sich die Erstprüfung faktisch fundiert automatisieren: Fristen, Anforderungen und Bedingungen werden zuverlässig extrahiert, Quellen angegeben und auf dieser Basis verständliche Analysen erstellt. Praxisimplementierungen zeigen signifikante Zeiteinsparungen und eine gesteigerte Angebotskapazität, ohne dass die Treue zu Compliance verloren geht.

Unternehmen, die jetzt in diese Technologie investieren, schaffen sich einen Wettbewerbsvorsprung. Sie können mit denselben Ressourcen mehr Ausschreibungen bearbeiten und frühzeitig ausschließen, welche Projekte unnötig viel Aufwand bringen. Gleichzeitig erhöht die klare Nachvollziehbarkeit der KI-Ergebnisse das Vertrauen der Fachleute in die Lösung. Unserer Einschätzung nach ist RAG – im Vergleich zu Alternativen wie aufwändigem Fine-Tuning – derzeit die technologisch überlegene Architektur für die automatisierte Ausschreibungsanalyse.

👉🏽 Sie möchten mehr über KI im Vertrieb erfahren?

In unserer Live-Veranstaltung (inkl. Rechenzentrumsführung) zeigen wir, wie intelligente KI-Lösungen beispielsweise die Bearbeitung von Ausschreibungen optimieren.

Jetzt anmelden:

https://www.telemaxx.de/ueber-uns/aktuelles/veranstaltungen/25072025-ki-anwendungen-auf-telemaxx-opencloud-mit-rechenzentrumsfuehrun

Teilen Sie diesen Artikel

.png)

%20(3000%20x%202000%20px).png)

.png)